La correction des biais de l’intelligence artificielle est un préalable à son déploiement harmonieux dans bien des domaines. Ces biais découlent de sa structure propre, mais aussi des nôtres puisque nous la concevons et/ou l’entrainons – y compris à notre insu. Les conducteurs de voitures bardées de capteurs entrainent les IA qui seront demain dans les voitures autonomes. Les textes flous ou les panneaux de signalisation que nous devons parfois reconnaître avant de pouvoir accéder à un site web permettent d’améliorer les algorithmes de reconnaissance visuelle. Chacune de nos traces, collectées sous forme de Big Data, fait de chacun de nous un professeur. Parfois à notre insu, nous partageons donc cette responsabilité non seulement collectivement, mais également individuellement.

Concepteurs ou entraineurs, nous nous devons donc de montrer l’exemple à l’IA. Être exemplaire implique de travailler spécifiquement à réduire nos propres biais afin de ne pas donner à l’IA de mauvaises habitudes. Simultanément, les acteurs reposant sur l’exploitation de ces biais opposeront sans doute une résistance à toute tentative de les atténuer, sauf à se renouveler.

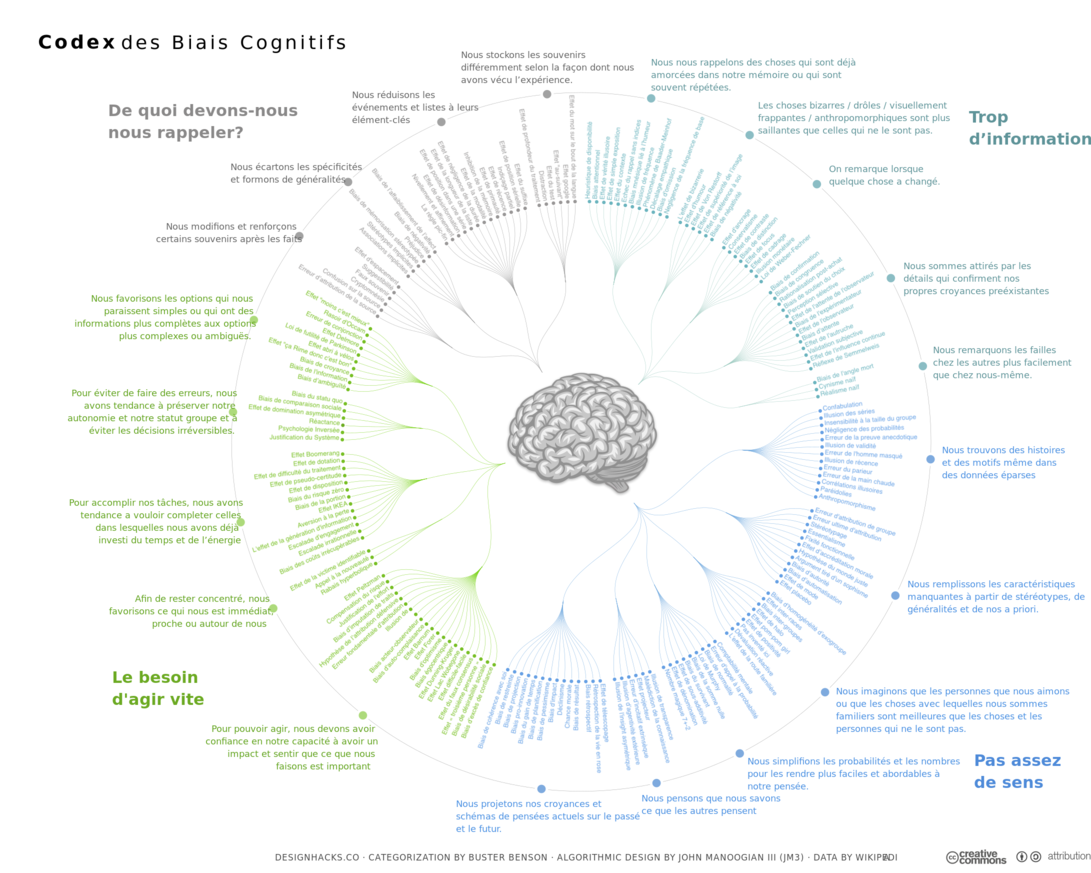

Nos biais découlent au moins en partie de mécanismes évolutifs. À défaut d’être en phase avec le réel qui nous entoure, ces heuristiques nous permettent de faire des choix en lien avec l’étendue et les limites de nos capacités de perception, d’action, et avec nos vulnérabilités spécifiques (source). Nous, humains, ne pouvons percevoir, agir, vivre que dans le périmètre accessible à nos deux bras, transportés par nos deux jambes. Nos biais sont, au mieux, ces sacrifices consentis à une adéquation maximale avec le monde qui nous entoure, et qui contribuent pourtant à notre survie.

Les capacités de l’IA sont très différentes des nôtres, car elle est construite sur le numérique. Les données qu’elle prend en compte sont bien moins limitées dans le temps et dans l’espace que celles que nos cinq sens nous relaient. Les actions qu’elle peut déclencher peuvent se déployer simultanément pour tous à l’échelle de la planète (ex. PageRank, RankBrain ou EdgeRank). Structurellement, le déploiement de l’IA se profile donc sous forme de silos hégémoniques, en continuité avec ceux autour desquels se concentrent les usages du web.

C’est la pluralité des personnalités humaines qui assure la résilience intrinsèque de l’espèce. Nous pouvons ainsi tirer parti de nos inévitables erreurs pour ne plus les reproduire. Cette optimisation est d’abord individuelle avant d’être collective. En silos hégémoniques, quasi instantanée et quasi ubiquitaire, aucune résilience de ce type n’est envisageable pour l’IA. Compter sur le nombre et la diversité des IAs, ou sur la sophistication de leurs processus d’apprentissage, pour que les biais des unes compensent les biais des autres, à l’image des sociétés humaines (qui sont à la peine), est donc un pari très osé. L’IA est intrinsèquement fragile.

Par conséquent, éduquer l’IA en incluant les biais découlant de notre propre évolution serait probablement particulièrement inadéquat. L’IA apprend à travers des exemples. Ce serait problématique qu’elle suive l’exemple des humains, car elle n’est pas humaine. Là où nous, humains, essayons de modeler nos biais a posteriori, souvent incapables de nous en défaire a priori, notre éthique est toujours en retard. Un retard de quelques heures, quelques jours, est compatible avec nos jambes et avec nos bras. Pour une IA qui traverse le monde instantanément grâce au numérique, un retard que nous aurions à subir, même infime pour elle, aurait proportionnellement des conséquences considérables pour nous.

En partie inspiré de cet article.